这一AI联盟的目的已超出芯片生产范畴,将能源、数据中心容量等内容囊括其中。据知情人士透露,OpenAI认为,AI系统需要大量能源,这也是科技行业面临的最大基建挑战之一。

人无远虑,必有近忧。然而对奥尔特曼来说,OpenAI可谓既有近忧——芯片,还有远虑——能源。

据媒体消息称,OpenAI的CEO奥尔特曼一直致力于在政府与行业领导者之间建立一个全球AI联盟,其主要议题已超出芯片生产范畴,将能源、数据中心容量等内容囊括其中。

知情人士称,本周奥尔特曼在阿联酋会见了投资者与政府官员,讨论私营部门如何与各国政府合作,以支持昂贵的大规模AI基础设施建设。不仅如此,奥尔特曼还与一些西方国家官员交流,并将在本周晚些时候在华盛顿举行会议。

奥尔特曼与全球官员的接触超出了先前的已知范围。最新被曝的这些会议也象征着奥尔特曼的更进一步努力,也透露出他对芯片和其他关键基建供应跟不上AI快速部署的担忧。

据一位熟悉OpenAI想法的人士透露,OpenAI认为,AI系统需要大量能源,这也是科技行业面临的最大基建挑战之一。此前奥尔特曼曾谈到,推动AI发展需要实现能源突破,且太阳能与核聚变可供支持AI发展。

值得一提的是,3月末AI初创公司OpenPipe联合创始人、CEO Kyle Corbitt曾透露,自己最近与一位负责GPT-6训练集群项目的微软工程师谈过,后者抱怨称,在跨区域GPU之间部署infiniband级别链接,实在是一件痛苦的事。

Corbitt问及为何不将训练集群集中在同一区域,这位微软工程师回答道,“哦我们已经尝试过那么做了,但是如果在一个州放置超过10万片H100 GPU,电网就会崩溃。”——一定程度上,这也能看出为何奥尔特曼急于想解决AI的能源问题。

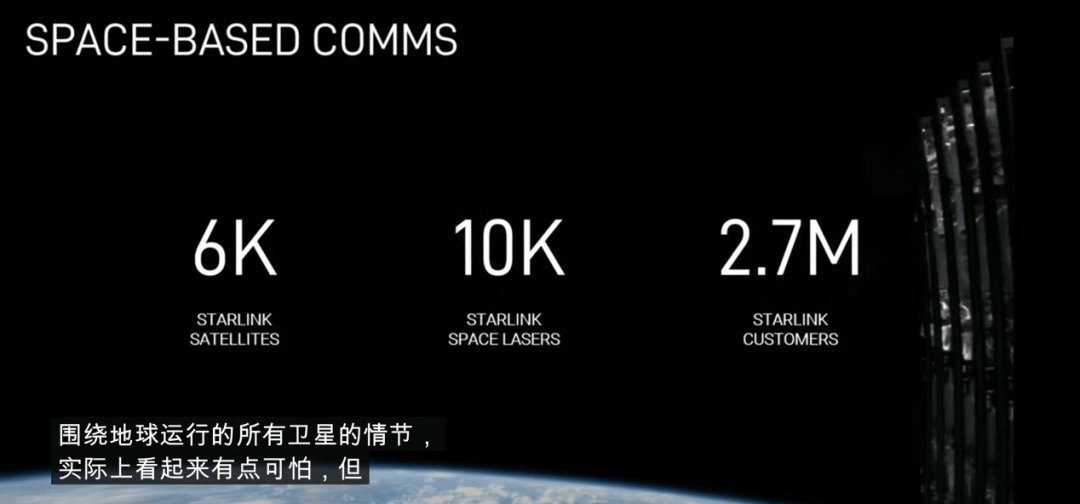

多位重磅人物发声:注意AI能耗需求

有数据显示,ChatGPT每天需要消耗超过50万千瓦时的电力,用于处理约2亿个用户请求,相当于美国家庭日用电量的1.7万多倍;至于搜索巨头谷歌,若其在每次用户搜索中都调用AIGC,年耗电量将增至290亿千瓦时左右,这甚至高于侏儒肯尼亚、危地马拉等国一年的用电量。

事实上,随着AI发展逐步推进,业内已有多位重量级人物发声,提醒AI的高能耗需求。

例如Arm首席执行官Rene Haas本周采访时就预计,到2030年AI数据中心的耗电量可能高达美国电力需求的20%-25%,而目前这一比例可能还只有4%或更少。

马斯克也表示,“我在一年多前就预测过芯片短缺,下一个短缺的将是电力。我认为明年将没有足够的电力来运行所有的芯片”。

比尔•盖茨更直言,电力是决定数据中心能否盈利的关键,AI所消耗的电量是惊人的。AI的使用将推升能源需求,未来几年,AI的发展可能会受制于芯片设计与电力供应。

这种担忧已在现实中有所反映:由于新数据中心的建设速度高于新建发电厂,供需差距已经开始出现。美国商业不动产服务公司世邦魏理仕(CBRE Group, Inc.)指出,由于电力供应延迟,数据中心的建设时间已经延长了2到6年。