2024年以来,大模型的价格出现了显著的下降趋势,并且是全球性的。

海外AI巨头,OpenAI和谷歌都在五月的新品发布会上,下调了模型调用价格。

OpenAI的GPT-4o支持免费试用,调用API的价格也比GPT-4-turbo降低了一半,为5 美元/百万tokens。谷歌的当家王牌Gemini大模型系列,Gemini 1.5 Flash 的价格为0.35美元/百万tokens,比GPT-4o 便宜得多。

同样的“价格战”,也在国内开打。

5月13日智谱AI上线了新的价格体系,入门级产品GLM-3 Turbo模型,调用价格从5 元/百万tokens,降至1元/百万tokens。紧随其后的字节跳动,正式发布豆包大模型家族,其中的豆包通用模型Pro 32k模型,定价为0.0008元/千tokens。

当一串代表价格的数字,成为各家发布会上最显眼的一页、最广为传播的信息,其他厂商为了不失去曝光度,不流失现有用户,当然也要有所表示,被动跟进,加入“价格战”。

就在今天,5月21日,阿里云也抛出重磅炸弹,宣布通义千问主力模型Qwen-Long,API输入价格降至0.0005元/千tokens。

大模型价格正在竞底,但究其本质,向下竞底是不具备“向上定价”的条件。将“降价”而非“卖贵”作为核心竞争力的大模型,是走不长远的。

降价的本质

是无法“向上定价”

大模型百万tokens价格一再跳水,OpenAI说是为了“造福世界”,谷歌说是为了扩大AI用户,国产大模型厂商也纷纷表示要让利个人和企业开发者。

那为什么ChatGPT、Gemini刚问世的时候,就敢于强势向开发者收钱呢?那时怎么不践行“造福世界”的初心呢?

我们越过那些官方的宣传辞藻,来看几组行业数据,就会发现:降价是一种必然。

第一,模型能力正在趋同,OpenAI/谷歌也没有护城河。

数据显示,自GPT-4发布以来,多个模型在GPT-4水平性能上的巨大收敛,然而并没有明显领先的模型。

就是大家都在向GPT-4看齐,但谁都没有突出优势。能力趋同的前提下,不得不放弃收费,靠降价/免费来争夺用户,保住地盘。

第二,大模型的边际收益正在持续走低。

Gary Marcus 博士在“Evidence that LLMs are reaching a point of diminishing returns — and what that might mean”《LLMs正达到收益递减的证据——及其可能意味着什么》一文中提到,从GPT-2到GPT-4甚至GPT-4 Turbo的性能变化,已经出现了性能递减的迹象。

在收益递减的背景下,意味着处理相同的任务,开发者的实际成本是在上升的。在AI创新商业化前景还不明朗的市场环境下,为了保住现有用户,大模型厂商必须给出有吸引力的对策。包括提供更小的模型,比如谷歌推出的Gemini 1.5 Flash,通过“蒸馏”实现了与Gemini 1.5 Pro性能接近、成本更低。另一个手段就是直接降价。

综上,大模型降价的本质,是因同质化竞争+投入产出比降低,而无法卖贵、不敢卖贵的必然选择。

向下竞底的前途

是没有前途

论迹不论心,只要大模型厂商的降价行动,能够切实惠及企业和开发者,当然是受市场欢迎的。

问题就在这里,企业和开发者能从中获得多大收益呢?

有人说,降低成本能推动大模型的“价值创造”,是错误的因果归因。大模型的“价值创造”,是以大模型本身为锚点,而非价格。

最直接的例子,ChatGPT问世即付费,当时很多从业者都很开心,认为市场终于重返工程师主导的文化,技术为王,代码竞争,“没有那些精心设计的流量游戏或者运营技巧,没人会动砍一刀送1000个token的心思”。说明明码标价、为好东西付费的模式,才是开发者心中的良性商业模式。

差的商业模式是什么?是模型能力不行,企业和个人开发者投入了大量时间、精力,结果无法建立竞争力,无法从应用创新中获得商业回报。

有一个SaaS开发者直言:“我们折腾了一年(做基于LLM的产品),也有不少用户提出了付费需求,但我们感觉做不到SLA,全部婉拒了。”所谓SLA,是指一定开销下,服务商与用户之间的一种协定,来保障服务的性能和可靠性。

开发者和ISV服务商,如果被低价吸引,但底座模型的能力却不行,不能解决用户的问题,赚不到钱,还投入了大量研发资金和工程团队,那最后实际的沉没成本,可比调用省下的仨瓜俩枣大多了。

正如微软所强调的那样,大模型“仍将是解决众多复杂任务的黄金标准”。所以,良性的商业模式,是大模型能力持续提升,商业化版本上同时兼顾普惠。

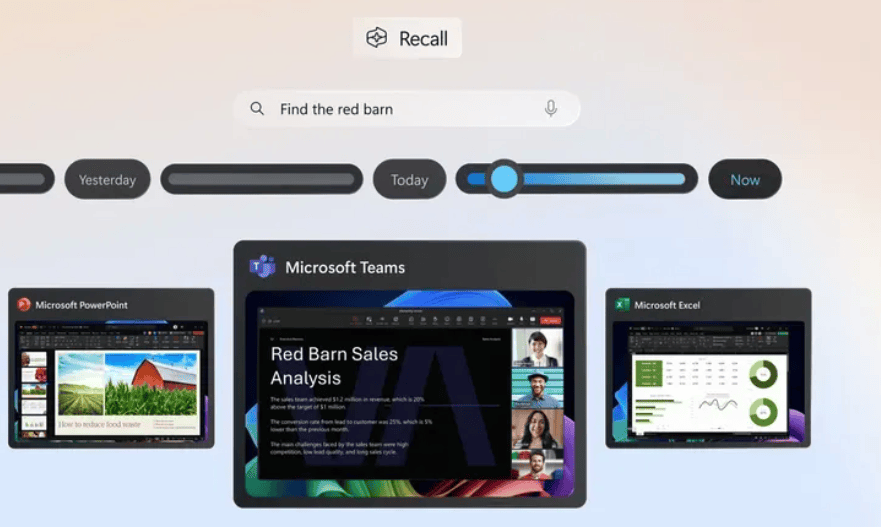

以下图来说,逐步进入到低价高质的绿色区域,也是“最具吸引力象限”。

从图中不难看到,GPT-4o是目前质量最高、价格相对降低的位置。

而放眼国内的厂商,模型能力如果达不到OpenAI的水平,一味拼价格并不是一个好策略。

可以推演一下,打价格战,会发生三种情况:

最乐观、最好的结果,是大模型厂商靠低价吸引用户,用户数量和使用量的规模化增加,能够低效甚至超过降价的亏损,实现盈利。而即使是最好的情况,大模型企业也会在短期内,利润受到挤压,财务表现可能会受到来自资本市场或投资人的压力。

至少目前来看,可能性很小。降价或许能够吸引不少用户尝鲜、试用,但最终模型能力才是沉淀下来的主因,留存率并不一定理想。

用户增长不确定,大模型投资成本却在节节攀升,意味着大模型厂商的风险敞口不断扩大,由此带来打价格战的一种最坏情况:国内大模型厂商被迫跟进价格战,不断压缩本就不大的盈利空间。

Anthropic的CEO曾向媒体透露,目前正在训练的模型成本已接近10亿美元,到2025年和2026年,将飙升至50亿或100亿美元。

这意味着,一旦大模型企业为了“价格战”,现金流会持续承压,缺乏充足的资金投入到招募AI人才、升级基础设施、部署数据中心、升级网络等投资中去,模型进化与迭代也会受到影响,从而让国产基座模型进入发展瓶颈期,与世界一流水平的差距越拉越大。

需要注意的是,社会各界用户早已在各个模型厂商的宣传布道中,拔高了对大模型的期望值。一味推广低质低价的使用体验,让人们对AI失去信心,觉得大模型不够万能、啥都干不好,对这一轮大模型主导的AI热潮,将是极大的负面影响。

当然,也不必过于焦虑。最坏情况和最好情况一样,发生的概率不大。现实中最有可能的,是大模型行业在最佳和最坏情况之间震荡。

一部分模型性能领先、商业模式向好、客情关系良好、现金流相对充裕的厂商,能够在跟进降价的同时,保持对底层创新的持续投资,但长期可以摊薄研发成本,靠规模增长来实现收入上涨。而注定也有一部分企业会在价格战与现金流压力下,被震荡出局。

一个AI公司创始人就表示:其实挺期待AGI到来的,虽然能秒灭我们这种小团队,但至少大家都解脱了。

说到底,一味打价格战,AI巨头有没有前途,不一定,但创新型小公司,一定危险。

降价的前提

是有“向上定价”的实力

有必要叠个甲,我们不反对大模型降价,鼓励大模型厂商为个人和企业开发者减轻负担。

只不过,当舆论各方都关注“低价”的时候,当一场大模型发布会的亮点是百万token价格小数点后有几位,当大模型的商业模式从技术为王,变成“羊毛出在猪身上”、把用户当成流量商品……有必要再重申一下:新技术,是大模型产业的“震中”。

高科技领域,新技术层出不穷。企业要在一波又一波技术浪潮中,同时扮演“颠覆者”和“防御者”。拿大模型来说,厂商必须有至少两个梯队来参与竞争。

一个梯队负责进攻,孵化全新的模型和产品,追逐技术上的颠覆式创新;另一个梯队负责防御,通过低价、生态等守住现有业务和用户,抵御对手的袭击。

而当前,大模型厂商的更优先事务,不是“向下降价”,而是塑造“向上定价”的可能性。

将自家大模型矩阵中的某一些特定模型,做一个极致低价,是很容易操作和吸引眼球的。能把大模型卖出去,向上定价,向价格段的上游迁移,才是AI实力的体现,才能让企业保有更长的生命力。

举个例子,GPT-4o虽然免费,但免费版本只提供有限的次数,而天花板级别的语音交互能力又带来了极强的付费潜力。此外,GPT-5也早就被曝已经做出来了,只是OpenAI没决定好何时推向市场。谷歌也采用类似的策略,更低价格、更低成本的模型,与高性能的付费模型,以及庞大的软硬件生态来让AI落地,共同构成商业版图。

当前国产大模型亟待完成的,是能力突破的技术进击。

从我们了解的大模型使用情况来看,企业和个人开发者最在意的商业化问题,仍然要靠模型本身的进化来解决,比如说:

目前阶段,很多任务场景,大模型连兜底的效果都还没有搞定,距离SLA级别的收费标准差距很大,无法达到商用;

精调虽然可以满足一部分场景,但难以泛化。有些场景的大模型精调效果,还不如用传统的小模型。这不是大模型“够不够便宜”的问题,是“为什么要用”的问题;

最终用户愿意付费的AI应用,必须真正做到降本增效,学习成本高一点都不会用。这就需要服务商和开发者详细地拆解任务流程,不忽视任何微小的业务细节,量身定制,降低整个开发过程的周期和难度,或许比降价更有吸引力。

其实,大模型质价比的“最具吸引力象限”,已经说明了,质量做高的前提下,实现价格更优,才是大模型商业化的可持续之路。

向下竞底只是权宜之计,能够“向上定价”的大模型才有未来。